Apache Hadoop ist eine Big-Data-Lösung zum Speichern und Analysieren großer Datenmengen. In diesem Artikel werden wir die komplexen Einrichtungsschritte für Apache Hadoop detailliert beschreiben, damit Sie so schnell wie möglich mit Ubuntu beginnen können. In diesem Beitrag installieren wir Apache Hadoop auf einem Ubuntu 17.10 Maschine.

Ubuntu-Version

Für diese Anleitung verwenden wir Ubuntu Version 17.10 (GNU/Linux 4.13.0-38-generisch x86_64).

Aktualisieren vorhandener Pakete

Um die Installation für Hadoop zu starten, ist es notwendig, dass wir unseren Computer mit den neuesten verfügbaren Softwarepaketen aktualisieren. Wir können dies tun mit:

sudo apt-get update && sudo apt-get -y dist-upgradeDa Hadoop auf Java basiert, müssen wir es auf unserem Computer installieren. Wir können jede Java-Version über Java 6 verwenden. Hier verwenden wir Java 8:

sudo apt-get -y install openjdk-8-jdk-headlessHadoop-Dateien herunterladen

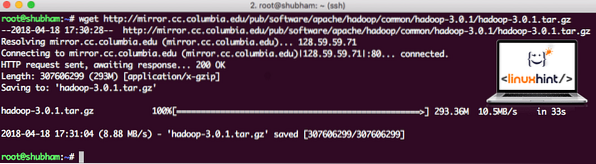

Alle notwendigen Pakete sind jetzt auf unserer Maschine vorhanden. Wir sind bereit, die erforderlichen Hadoop-TAR-Dateien herunterzuladen, damit wir sie einrichten und auch ein Beispielprogramm mit Hadoop ausführen können.

In dieser Anleitung installieren wir Hadoop v3.0.1. Laden Sie die entsprechenden Dateien mit diesem Befehl herunter:

wget http://mirror.cc.Columbia.edu/pub/software/apache/hadoop/common/hadoop-3.0.1/Hadoop-3.0.1.Teer.gzJe nach Netzwerkgeschwindigkeit kann dies einige Minuten dauern, da die Datei groß ist:

Hadoop herunterladen

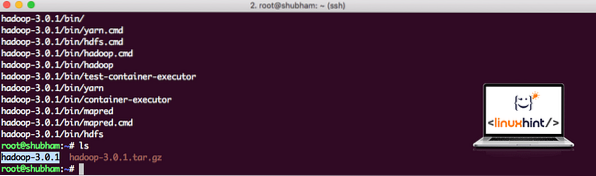

Hier finden Sie die neuesten Hadoop-Binärdateien. Nachdem wir die TAR-Datei heruntergeladen haben, können wir sie in das aktuelle Verzeichnis extrahieren:

tar xvzf hadoop-3.0.1.Teer.gzDies dauert aufgrund der großen Dateigröße des Archivs einige Sekunden:

Hadoop nicht archiviert

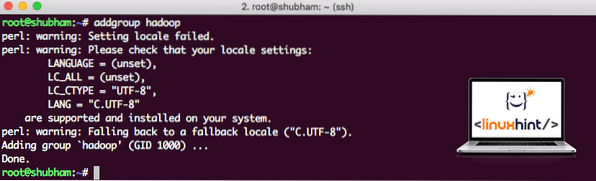

Neue Hadoop-Benutzergruppe hinzugefügt

Da Hadoop über HDFS arbeitet, kann ein neues Dateisystem auch unser eigenes Dateisystem auf dem Ubuntu-Rechner stören. Um diese Kollision zu vermeiden, erstellen wir eine komplett separate Benutzergruppe und weisen sie Hadoop zu, damit sie ihre eigenen Berechtigungen enthält. Mit diesem Befehl können wir eine neue Benutzergruppe hinzufügen:

addgroup hadoopWir werden so etwas sehen:

Hadoop-Benutzergruppe hinzufügen

Wir sind bereit, dieser Gruppe einen neuen Benutzer hinzuzufügen:

useradd -G hadoop hadoopuserBitte beachten Sie, dass alle von uns ausgeführten Befehle als Root-Benutzer selbst ausgeführt werden. Mit dem Befehl aove konnten wir der von uns erstellten Gruppe einen neuen Benutzer hinzufügen.

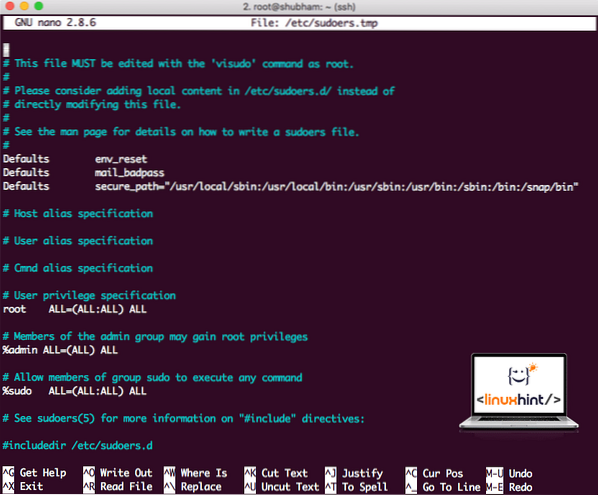

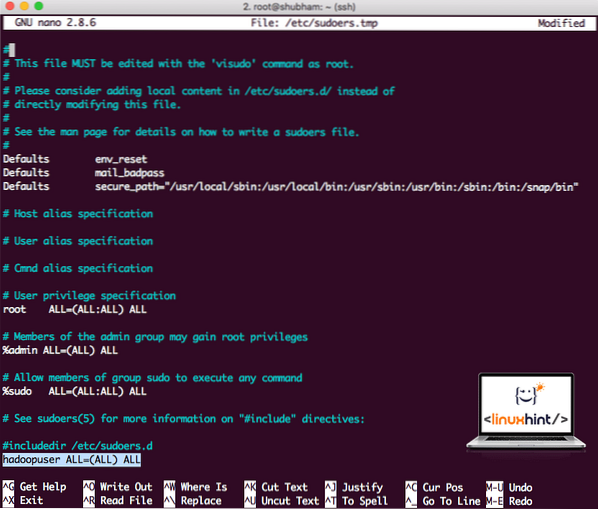

Damit der Hadoop-Benutzer Operationen ausführen kann, müssen wir ihm auch Root-Zugriff gewähren. Öffne das /etc/sudoers Datei mit diesem Befehl:

sudo visudoBevor wir etwas hinzufügen, sieht die Datei so aus:

Sudoers-Datei, bevor Sie etwas hinzufügen

Fügen Sie am Ende der Datei folgende Zeile hinzu:

hadoopuser ALLE=(ALLE) ALLENun sieht die Datei so aus:

Sudoers-Datei nach dem Hinzufügen eines Hadoop-Benutzers

Dies war die wichtigste Einrichtung, um Hadoop eine Plattform zum Ausführen von Aktionen zur Verfügung zu stellen. Wir sind jetzt bereit, einen Hadoop-Cluster mit einem einzelnen Knoten einzurichten.

Hadoop-Einzelknoten-Setup: Standalone-Modus

Wenn es um die wahre Leistungsfähigkeit von Hadoop geht, wird es normalerweise auf mehreren Servern eingerichtet, damit es auf eine große Menge an vorhandenen Datensätzen skaliert werden kann Hadoop verteiltes Dateisystem (HDFS). Dies ist normalerweise in Debugging-Umgebungen in Ordnung und wird nicht für den Produktionseinsatz verwendet. Um den Prozess einfach zu halten, erklären wir hier, wie wir ein Single-Node-Setup für Hadoop durchführen können.

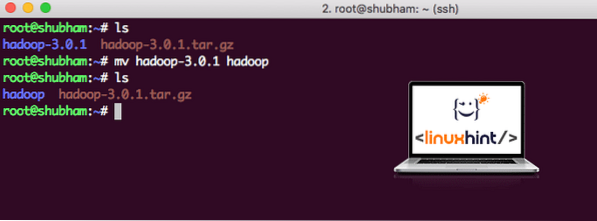

Sobald wir mit der Installation von Hadoop fertig sind, werden wir auch eine Beispielanwendung auf Hadoop ausführen. Ab sofort heißt die Hadoop-Datei hadoop-3.0.1. Benennen wir es zur einfacheren Verwendung in hadoop um:

mv hadoop-3.0.1 hadoopDie Datei sieht jetzt so aus:

Hadoop verschieben

Es ist an der Zeit, den zuvor erstellten Hadoop-Benutzer zu verwenden und diesem Benutzer das Eigentum an dieser Datei zuzuweisen:

chown -R hadoopuser:hadoop /root/hadoopEin besserer Speicherort für Hadoop ist das Verzeichnis /usr/local/, also verschieben wir es dorthin:

mv hadoop /usr/local/cd /usr/local/

Hadoop zum Pfad hinzufügen

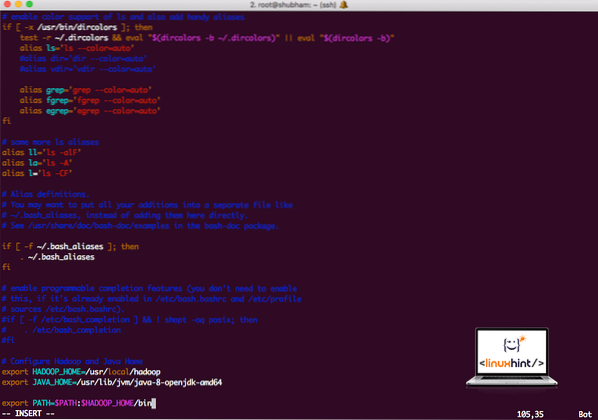

Um Hadoop-Skripte auszuführen, werden wir es jetzt zum Pfad hinzufügen. Öffnen Sie dazu die bashrc-Datei:

vi ~/.bashrcFüge diese Zeilen an das Ende des .bashrc-Datei, sodass der Pfad den Pfad der ausführbaren Hadoop-Datei enthalten kann:

# Hadoop- und Java-Startseite konfigurierenexport HADOOP_HOME=/usr/local/hadoop

export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64

export PFAD=$PFAD:$HADOOP_HOME/bin

Datei sieht so aus:

Hadoop zum Pfad hinzufügen

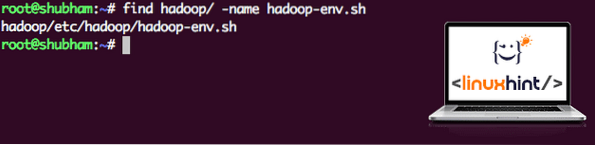

Da Hadoop Java verwendet, müssen wir die Hadoop-Umgebungsdatei mitteilen hadoop-env.Sch wo es sich befindet. Der Speicherort dieser Datei kann je nach Hadoop-Version variieren. Um leicht herauszufinden, wo sich diese Datei befindet, führen Sie den folgenden Befehl direkt außerhalb des Hadoop-Verzeichnisses aus:

find hadoop/ -name hadoop-env.SchWir erhalten die Ausgabe für den Dateispeicherort:

Speicherort der Umgebungsdatei

Bearbeiten wir diese Datei, um Hadoop über den Java-JDK-Speicherort zu informieren, fügen Sie dies in die letzte Zeile der Datei ein und speichern Sie sie:

export JAVA_HOME=/usr/lib/jvm/java-8-openjdk-amd64Die Installation und Einrichtung von Hadoop ist nun abgeschlossen. Wir sind bereit, unsere Beispielanwendung jetzt auszuführen. Aber warte, wir haben noch nie eine Musterbewerbung gemacht!

Ausführen der Beispielanwendung mit Hadoop

Tatsächlich enthält die Hadoop-Installation eine integrierte Beispielanwendung, die ausgeführt werden kann, sobald wir mit der Installation von Hadoop fertig sind. Klingt gut, oder?

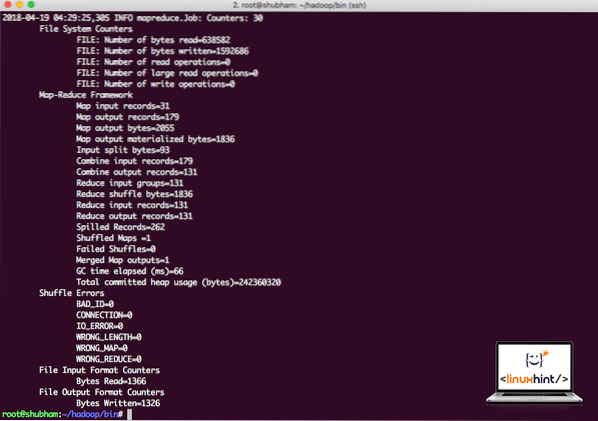

Führen Sie den folgenden Befehl aus, um das JAR-Beispiel auszuführen:

hadoop jar /root/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.0.1.jar wordcount /root/hadoop/README.txt /root/AusgabeHadoop zeigt an, wie viel Verarbeitung es am Knoten gemacht hat:

Hadoop-Verarbeitungsstatistiken

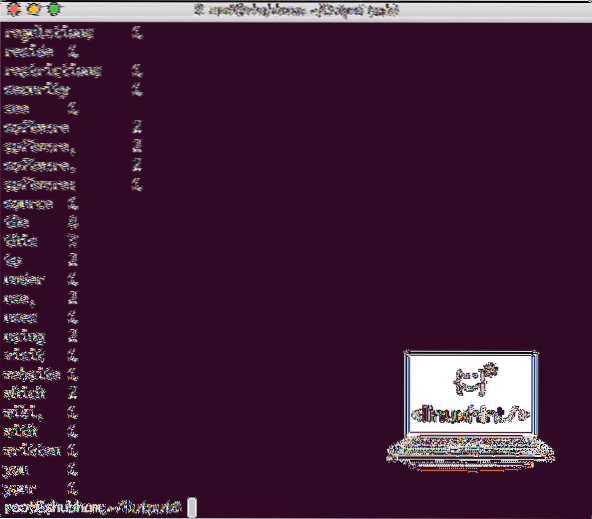

Sobald Sie den folgenden Befehl ausführen, sehen wir die Datei part-r-00000 als Ausgabe. Gehen Sie weiter und sehen Sie sich den Inhalt der Ausgabe an:

katze teil-r-00000Sie erhalten so etwas wie:

Word Count-Ausgabe von Hadoop

Fazit

In dieser Lektion haben wir uns angesehen, wie wir Apache Hadoop unter Ubuntu 17 installieren und verwenden können.10 Maschine. Hadoop eignet sich hervorragend zum Speichern und Analysieren großer Datenmengen und ich hoffe, dieser Artikel wird Ihnen helfen, schnell mit der Verwendung unter Ubuntu zu beginnen.

Phenquestions

Phenquestions