Apache Kafka

Lassen Sie uns für eine High-Level-Definition eine kurze Definition für Apache Kafka präsentieren:

Apache Kafka ist ein verteiltes, fehlertolerantes, horizontal skalierbares Commit-Log.

Das waren einige hochrangige Worte über Apache Kafka. Lassen Sie uns die Konzepte hier im Detail verstehen.

- Verteilt: Kafka teilt die darin enthaltenen Daten auf mehrere Server auf und jeder dieser Server ist in der Lage, Anfragen von Clients nach dem darin enthaltenen Datenanteil zu verarbeiten

- Fehlertoleranz: Kafka hat keinen Single Point of Failure. In einem SPoF-System, wie einer MySQL-Datenbank, wenn der Server, auf dem die Datenbank gehostet wird, ausfällt, ist die Anwendung kaputt. In einem System, das keinen SPoF hat und aus mehreren Knoten besteht, ist es für einen Endbenutzer immer noch dasselbe, selbst wenn der größte Teil des Systems ausfällt.

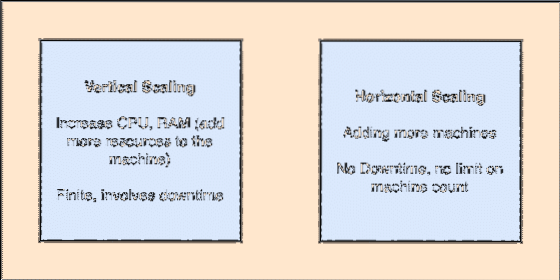

- Horizontal skalierbar: Diese Art der Skalierung bezieht sich auf das Hinzufügen weiterer Maschinen zu einem bestehenden Cluster. Dies bedeutet, dass Apache Kafka in der Lage ist, mehr Knoten in seinem Cluster zu akzeptieren und keine Ausfallzeiten für erforderliche Upgrades des Systems bereitzustellen. Sehen Sie sich das Bild unten an, um die Art der Sailing-Konzepte zu verstehen:

- Commit-Protokoll: Ein Commit-Log ist eine Datenstruktur, genau wie eine verknüpfte Liste. Es hängt alle Nachrichten an und behält immer ihre Reihenfolge bei. always. Daten können aus diesem Protokoll erst gelöscht werden, wenn eine bestimmte Zeit für diese Daten erreicht ist.

Vertikale und horizontale Skalierung

Ein Thema in Apache Kafka ist wie eine Warteschlange, in der Nachrichten gespeichert werden. Diese Nachrichten werden für einen konfigurierbaren Zeitraum gespeichert und die Nachricht wird erst dann gelöscht, wenn diese Zeit erreicht ist, auch wenn sie von allen bekannten Verbrauchern konsumiert wurde.

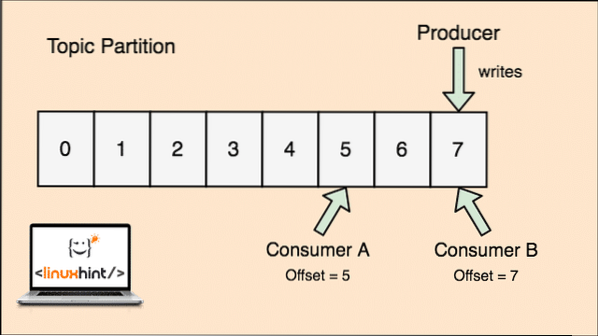

Kafka ist skalierbar, da es die Verbraucher sind, die tatsächlich speichern, welche Nachricht von ihnen zuletzt als "Offset"-Wert abgerufen wurde. Schauen wir uns eine Abbildung an, um dies besser zu verstehen:

Themenaufteilung und Consumer-Offset in Apache Kafka

Erste Schritte mit Apache Kafka

Um Apache Kafka verwenden zu können, muss es auf dem Computer installiert sein. Lesen Sie dazu Apache Kafka unter Ubuntu installieren.

Stellen Sie sicher, dass Sie über eine aktive Kafka-Installation verfügen, wenn Sie Beispiele ausprobieren möchten, die wir später in der Lektion vorstellen.

Wie funktioniert es?

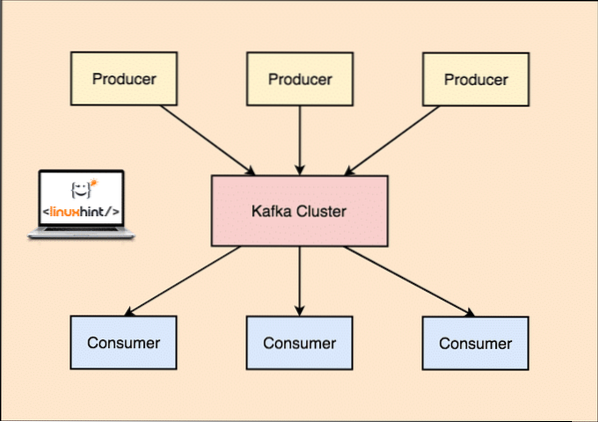

Mit Kafka, dem Produzent Anwendungen veröffentlichen Mitteilungen die bei einem Kafka . ankommt Knoten und nicht direkt an einen Verbraucher. Von diesem Kafka-Knoten werden Nachrichten von den Verbraucher Anwendungen.

Kafka Produzent und Konsument

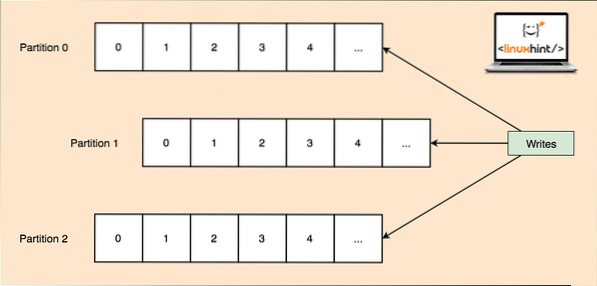

Da ein einzelnes Thema viele Daten auf einmal erhalten kann, ist Kafka horizontal skalierbar, jedes Thema ist unterteilt in Partitionen und jede Partition kann auf jeder Knotenmaschine eines Clusters leben. Versuchen wir es vorzustellen:

Themenpartitionen

Auch hier zeichnet Kafka Broker nicht auf, welcher Verbraucher wie viele Datenpakete verbraucht hat. Es ist der Verantwortung des Verbrauchers, den Überblick über die von ihm verbrauchten Daten zu behalten.

Persistenz auf Festplatte

Kafka behält die Nachrichtenaufzeichnungen, die er von den Produzenten erhält, auf der Festplatte und behält sie nicht im Speicher. Eine Frage, die sich stellen könnte, ist, wie dies machbar und schnell ist? Dafür gab es mehrere Gründe, die es zu einer optimalen Art der Verwaltung der Nachrichtensätze machen:

- Kafka folgt einem Protokoll zum Gruppieren der Nachrichtendatensätze. Producer produzieren Nachrichten, die in großen Blöcken auf der Festplatte gespeichert werden, und Consumer konsumieren diese Nachrichtendatensätze ebenfalls in großen linearen Blöcken.

- Der Grund dafür, dass die Schreibvorgänge auf der Festplatte linear sind, ist, dass die Lesevorgänge aufgrund der stark verkürzten linearen Lesezeit der Festplatte schnell sind.

- Lineare Plattenoperationen werden optimiert durch Betriebssysteme auch durch die Verwendung von Techniken von hinterschreiben und lesen Sie weiter.

- Moderne Betriebssysteme verwenden auch das Konzept von Seitencaching Das bedeutet, dass sie einige Festplattendaten im freien verfügbaren RAM zwischenspeichern.

- Da Kafka Daten im gesamten Fluss vom Produzenten bis zum Verbraucher in einheitlichen Standarddaten persistiert, nutzt es die Zero-Copy-Optimierung Prozess.

Datenverteilung und -replikation

Wie wir oben gesehen haben, dass ein Thema in Partitionen unterteilt ist, wird jeder Nachrichtendatensatz auf mehreren Knoten des Clusters repliziert, um die Reihenfolge und die Daten jedes Datensatzes beizubehalten, falls einer der Knoten stirbt.

Auch wenn eine Partition auf mehreren Knoten repliziert wird, gibt es immer noch Partitionsführer Knoten, über den Anwendungen Daten zum Thema lesen und schreiben, und der Leiter repliziert Daten auf anderen Knoten, die als bezeichnet werden Anhänger dieser Partition.

Wenn die Meldedatensatzdaten für eine Anwendung sehr wichtig sind, kann die Gewährleistung der Sicherheit des Meldedatensatzes in einem der Knoten erhöht werden, indem die Replikationsfaktor des Clusters.

Was ist Zookeeper??

Zookeeper ist ein sehr fehlertoleranter, verteilter Schlüsselwertspeichervalue. Apache Kafka hängt stark von Zookeeper ab, um Cluster-Mechaniken wie den Heartbeat zu speichern, Updates/Konfigurationen zu verteilen usw.).

Es ermöglicht den Kafka-Brokern, sich selbst zu abonnieren und zu wissen, wann immer eine Änderung bezüglich eines Partitionsführers und einer Knotenverteilung stattgefunden hat.

Hersteller- und Verbraucheranwendungen kommunizieren direkt mit Zookeeper Anwendung, um zu wissen, welcher Knoten der Partitionsführer für ein Thema ist, damit sie Lese- und Schreibvorgänge vom Partitionsführer ausführen kann.

Streaming

Ein Stream-Prozessor ist eine Hauptkomponente in einem Kafka-Cluster, der einen kontinuierlichen Strom von Nachrichtendatensatzdaten von Eingabethemen nimmt, diese Daten verarbeitet und einen Datenstrom zu Ausgabethemen erstellt, der alles sein kann, vom Papierkorb bis zu einer Datenbank.

Es ist durchaus möglich, eine einfache Verarbeitung direkt mit den Producer/Consumer-APIs durchzuführen, obwohl Kafka für komplexe Verarbeitungen wie das Kombinieren von Streams eine integrierte Streams-API-Bibliothek bereitstellt. Läuft nicht auf einem Broker. Es funktioniert ähnlich wie die Verbraucher-API und hilft uns, die Stream-Verarbeitungsarbeit über mehrere Anwendungen hinweg zu skalieren.

Wann sollte Apache Kafka verwendet werden??

Wie wir in den obigen Abschnitten untersucht haben, kann Apache Kafka verwendet werden, um mit einer großen Anzahl von Nachrichtendatensätzen umzugehen, die zu einer praktisch unendlichen Anzahl von Themen in unseren Systemen gehören können.

Apache Kafka ist ein idealer Kandidat, wenn es um die Nutzung eines Dienstes geht, der es uns ermöglicht, die ereignisgesteuerte Architektur in unseren Anwendungen zu verfolgen. Dies liegt an seinen Fähigkeiten der Datenpersistenz, der fehlertoleranten und stark verteilten Architektur, bei der sich kritische Anwendungen auf ihre Leistung verlassen können.

Die skalierbare und verteilte Architektur von Kafka macht die Integration mit Microservices sehr einfach und ermöglicht es einer Anwendung, sich von viel Geschäftslogik zu entkoppeln.

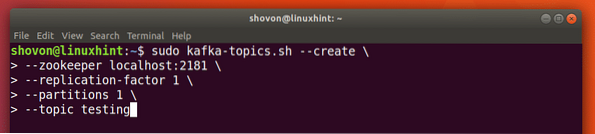

Erstellen eines neuen Themas

Wir können ein Testthema erstellen testen auf dem Apache Kafka-Server mit dem folgenden Befehl:

Ein Thema erstellen

sudo kafka-themen.sh --create --zookeeper localhost:2181 --replication-factor 1--Partitionen 1 --topic testing

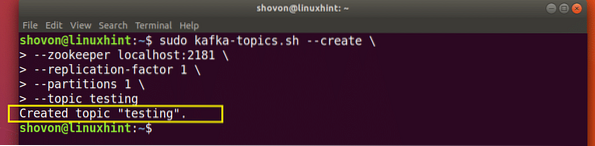

Folgendes erhalten wir mit diesem Befehl zurück:

Neues Kafka-Thema erstellen

Es wird ein Testthema erstellt, das wir mit dem genannten Befehl bestätigen können:

Kafka Topic-Erstellungsbestätigung

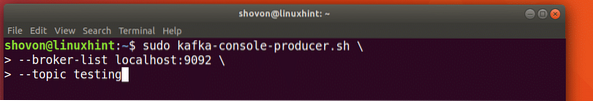

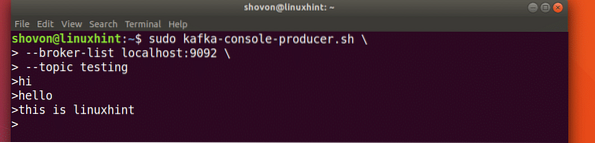

Nachrichten zu einem Thema schreiben Top

Wie wir bereits untersucht haben, ist eine der in Apache Kafka vorhandenen APIs die Hersteller-API. Wir verwenden diese API, um eine neue Nachricht zu erstellen und zu dem gerade erstellten Thema zu veröffentlichen:

Nachricht zum Thema schreiben

sudo kafka-console-producer.sh --broker-list localhost:9092 --topic testingSehen wir uns die Ausgabe für diesen Befehl an:

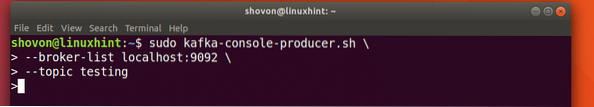

Nachricht an Kafka Topic veröffentlichen

Sobald wir die Taste drücken, sehen wir ein neues Pfeilzeichen (>), was bedeutet, dass wir jetzt Daten eingeben können:

Eine Nachricht eingeben

Geben Sie einfach etwas ein und drücken Sie , um eine neue Zeile zu beginnen. Ich habe 3 Textzeilen eingegeben:

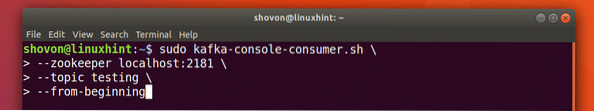

Nachrichten aus dem Thema lesen

Nachdem wir nun eine Nachricht zu dem von uns erstellten Kafka-Thema veröffentlicht haben, wird diese Nachricht für einige konfigurierbare Zeit da sein. Wir können es jetzt mit dem lesen Verbraucher-API:

Nachrichten aus dem Thema lesen

sudo kafka-console-consumer.sh --zookeeper localhost:2181 --Thementests --von Anfang an

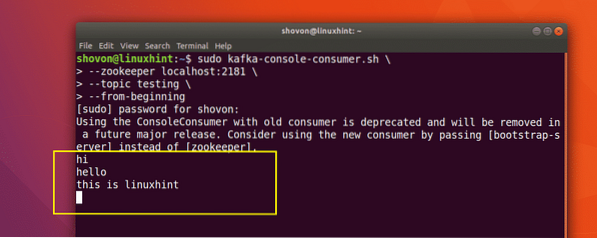

Folgendes erhalten wir mit diesem Befehl zurück:

Befehl zum Lesen der Nachricht von Kafka Topic

Wir können die Nachrichten oder Zeilen sehen, die wir mit der Producer API geschrieben haben, wie unten gezeigt:

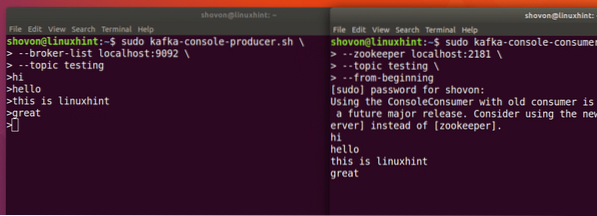

Wenn wir über die Producer API eine weitere neue Nachricht schreiben, wird diese auch sofort auf der Consumer-Seite angezeigt:

Gleichzeitig veröffentlichen und konsumieren

Fazit

In dieser Lektion haben wir uns angesehen, wie wir Apache Kafka verwenden, der ein ausgezeichneter Message Broker ist und auch als spezielle Datenpersistenzeinheit fungieren kann.

Phenquestions

Phenquestions